Хакеры активно используют генеративный ИИ для кибератак и исследуют новые способы использования других передовых языковых моделей, таких как ChatGPT.

Они используют большие языковые модели (LLM) и генеративный ИИ для различных целей, таких как фишинг, социальная инженерия, создание вредоносных программ, атаки с использованием учётных данных, фейковые новости, дезинформация, автоматизированные взломы и многое другое.

В преступном мире наблюдается рост предложений «jailbreak-as-a-service» – услуги, которая предоставляет анонимный доступ к легальным языковым моделям вроде ChatGPT и содержит постоянно обновляемые подсказки, чтобы обойти этические ограничения.

Jailbreak / Джейлбрейк (iPhone/iPod Touch/iPad/Apple TV/Apple Watch)

Процесс использования уязвимостей заблокированного устройства для установки программного обеспечения, отличного от предоставляемого производителем этого устройства. Джейлбрейк позволяет владельцу устройства получить полный доступ к операционной системе и всем функциям. Этот процесс также называется взломом.

Некоторые сервисы, такие как EscapeGPT и LoopGPT, открыто рекламируют джейлбрейк, а другие, например BlackhatGPT, сначала выдают себя за эксклюзивных поставщиков LLM, а потом выясняется, что они просто используют API OpenAI с подсказками для джейлбрейка.

EscapeGPT

Борьба между нарушителями закона, которые намерены победить цензуру искусственного интеллекта, и разработчиками, которые пытаются предотвратить взлом своих продуктов, привела к появлению нового нелегального рынка ИИ.

BlackHatGPT

Более того, в последнее время наблюдается всплеск мошеннических предложений, которые только утверждают, что они очень эффективны, но не имеют никаких преимуществ. Это могут быть мошенники или заброшенные проекты, такие как FraudGPT, которые активно рекламировались, но так и не были успешно реализованы.

Хакеры используют генеративный ИИ для двух основных целей:

- Разработка вредоносного ПО и вредоносных инструментов.

- Совершенствование тактики социальной инженерии путём разработки мошеннических сценариев и масштабирования фишинговых кампаний с использованием функций предоставляемых LLM.

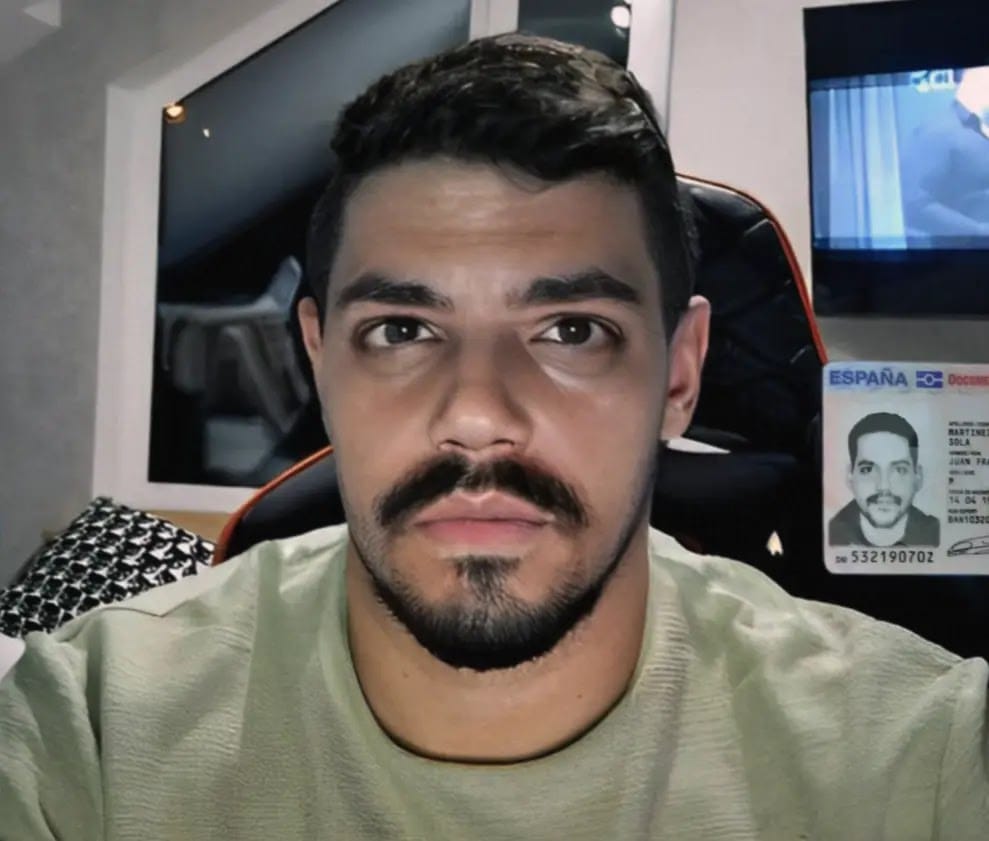

Кроме того, появляются услуги DeepFake. Хакеры предлагают манипуляции с изображениями и видео знаменитостей по цене от $10 до $500, включая целевые предложения по обходу проверки KYC в финансовых учреждениях с использованием искусственных личностей.

Deepfake. Фото Trend Micro

Искусственный интеллект расширяет возможности хакеров, и нам остаётся только гадать, с какими изощрёнными методами взлома или обмана мы можем столкнуться уже завтра.

Материалы: Gbhackers.com (Tushar Subhra Dutta)